Plik robots.txt jest przechowywany na serwerze w formacie tekstowym. Składa się on z łacińskich znaków i oznaczeń, które służą do tworzenia poleceń dla robotów dotyczących tego, które strony powinny być indeksowane, a które nie. Robots.txt jest tworzony przy użyciu standardowej składni, a jego dyrektywy są zrozumiałe dla robotów wszystkich wyszukiwarek. Jeśli ten plik nie zostanie użyty, wszystkie strony witryny będą indeksowane w sposób niedyskretny. Może to negatywnie wpłynąć na wyniki wyszukiwarek.

Co to jest plik robots.txt?

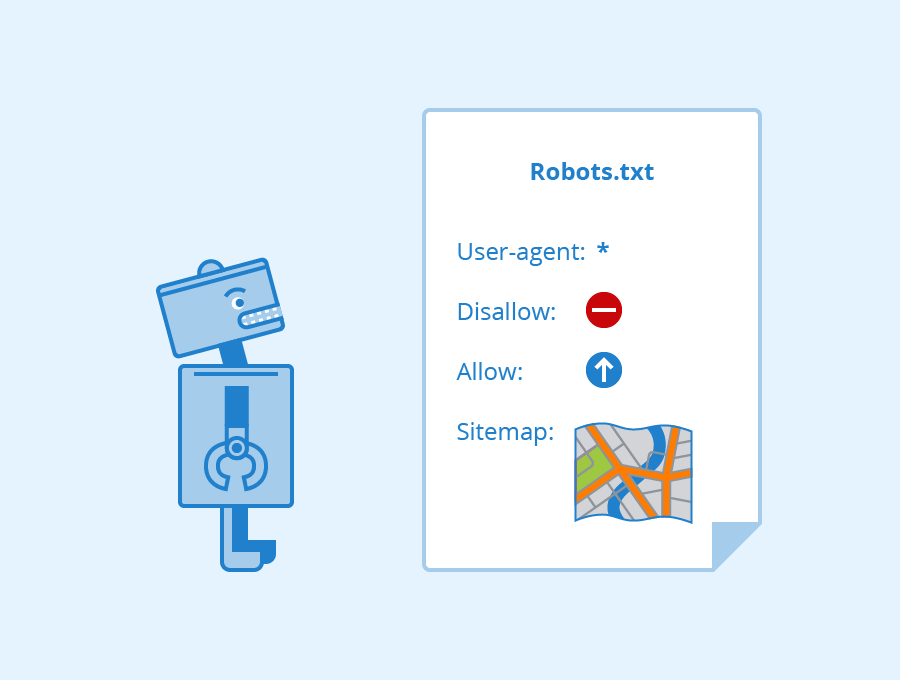

Jest to plik zawierający zwykły tekst składający się z co najmniej dwóch wierszy. Dokładna liczba słów zależy od indywidualnej potrzeby zakazania lub zezwolenia na przeglądanie określonych stron. Każdy wiersz pliku to jedno polecenie w formie dyrektywy. Opisuje on konkretną sekcję, kategorię lub stronę. Każda sekcja zaczyna się od nowego wiersza.

Robots.txt można edytować w dowolnym momencie, gdy zajdzie potrzeba usunięcia z indeksu duplikatów, danych osobowych, umowy z użytkownikiem lub nowych stron. W tym celu jest on przesyłany do menedżera plików i edytowany na komputerze. Po wprowadzeniu zmian należy ponownie przesłać zaktualizowany plik robots.txt na serwer i sprawdzić go pod linkiem yoursite.pl/robots.txt, gdzie yoursite.ru jest nazwą witryny.

Plik ten można również utworzyć w celu uniemożliwienia lub zezwolenia na indeksowanie wszystkich stron witryny jednocześnie. Można również użyć go do ukrywania określonych stron dla różnych robotów. Jeśli dyrektywy mają zastosowanie do wszystkich robotów, pierwszy wiersz powinien kończyć się gwiazdką „*”. W przypadku zwracania się do konkretnej wyszukiwarki jej nazwę należy wpisać w pierwszym wierszu dyrektywy User-agent.

Więcej o pliku robots txt przeczytasz na https://sempai.pl/blog/robots-txt-czym-jest-plik-robots-i-do-czego-sluzy/

Robot txt — co to i dlaczego go potrzebujesz?

- Określa listę stron, które mają być indeksowane;

- Zmniejszenie obciążenia serwera podczas przeglądania witryny przez roboty indeksujące wyszukiwarek;

- Określa główną witrynę lustrzaną;

- Ścieżka Sitemap;

- Definiowanie dodatkowych reguł przeglądania stron za pomocą dyrektyw.

Czasami roboty nie biorą pod uwagę dyrektyw zawartych w pliku robots.txt. Dzieje się tak z powodu błędów składni. Najczęstsze z nich to:

- Przekroczenie rozmiaru pliku (512KB dla Google);

- Błędy w przepisanych dyrektywach lub odsyłaczach;

- Format pliku nie jest tekstowy i/lub zawiera nieprawidłowe znaki;

- Plik jest niedostępny, gdy jest żądany z serwera.

Od czasu do czasu należy sprawdzić, czy plik robots.txt jest poprawny i dostępny oraz czy nie zawiera błędów składni. Przy okazji, niektóre systemy CMS i panele hostingowe umożliwiają edycję tego pliku z poziomu panelu administracyjnego.